友情链接:

天然NVIDIA现在在AI查验限制无可匹敌,但面临日益增长的即时推理需求,其正霸术一项足以改造行业模式的“机密火器”。

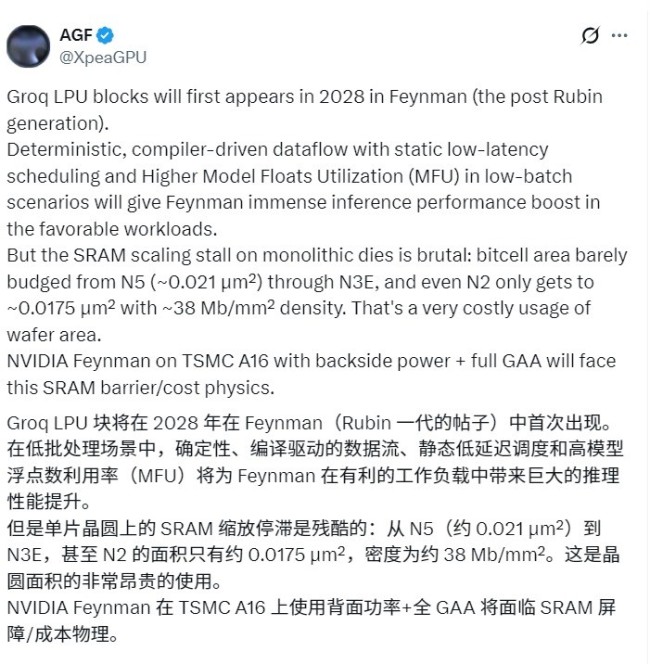

据AGF剖析,NVIDIA策划在2028年推出的Feynman(费曼)架构GPU中,整合来自Groq公司的LPU(话语处理单位),以大幅普及AI推感性能。

Feynman架构将接替Rubin架构,礼聘台积电开端进的A16(1.6nm)制程,为了冲突半导体物理遗弃,NVIDIA策划应用台积电的SoIC夹杂键合时代,将专为推理加快盘算推算的LPU单位平直堆叠在GPU之上。

这种盘算推算近似于AMD的3D V-Cache时代,但NVIDIA堆叠的不是粗拙缓存,而是专为推理加快盘算推算的LPU单位。

盘算推算的中枢逻辑在于贬责SRAM的微缩逆境,在1.6nm这种极致工艺下,平直在主芯片集成多数SRAM老本极高且占用空间。

通过堆叠时代,NVIDIA不错将运算中枢留在主芯片,而将需要多数面积的SRAM零丁成另一层芯片堆叠上去。

台积电的A16制程一大本性是因循后面供电时代,这项时代不错腾出芯片正面的空间,专供垂直信号流通,确保堆叠的LPU能以极低功耗进行高速数据交换。

连合LPU的“详情趣”扩充逻辑,改日的NVIDIA GPU在处理即时AI反馈(如语音对话、及时翻译)时,速率将收场质的飞跃。

不外这也存在两大潜在挑战,差别是散热问题和CUDA兼容性周折,在运算密度极高的GPU 再加盖一层芯片,如何幸免“热当机”是工程团队的头号周折。

同期LPU强调“详情趣”扩充次序,需要精准的内存建树,而CUDA生态则是基于硬件笼统化盘算推算的,要让这两者完整协同开云kaiyun,需要顶级的软件优化。

热点资讯